Virtual Instruments (www.virtualinstruments.com), émanation de Finisar, tente de trouver une légitimité mais risque bien de finir à la poubelle. Qui a besoin de ce truc ? On comprend que l'optimisation d'une infrastructure SAN est importante surtout côté budget, c'est tellement cher. Virtual Instruments, rien que le nom est une misère, vient de sortir sa nouvelle solution - VirtualWisdom - qui vise à accomplir la même chose que le produit précédent en mieux c'est-à-dire monitoring et troubleshooting du réseau de stockage Fibre Channel. A vendre, cela doit être un enfer, je plains les équipes commerciales qui tente de faire adopter une solution chère et inutile. L'idée est faire vivre un peu plus longtemps des infrastructures coûteuses et difficiles à amortir en leur ajoutant un élément supplémentaire retardant l'amortissement et disons-le qui apporte alors quelques bénéfices, je ne m'y trompe pas... Et puis, qu'est-ce que John W. Thompson, héros de l'ambition Symantec avec Norton et l'acquisition de Veritas Software, est allé faire dans cette galère, venu en tant que Chairman il y a quelques mois, on espérait que sa claque des "10 en 10" chez Symantec le ferait se cacher mais non il sort de sa tanière et a même été nommé CEO récemment. Alors pourquoi ? C'est plus simple, moins risqué et la culbute à la vente bien meilleure alors que 10Mds$ en 2010 chez Symantec relève de l'utopie. Reconnaissons-lui sa très bonne capacité à exécuter une stratégie, de sentir le marché et surtout dans le cas de Virtual Instruments de son formidable carnet d'adresses bien utile comme porte de sortie car il n'y a aura pas d'IPO. Le board ne s'y est pas trompé, il faut une stratégie de sortie, le futur du stockage étant Ethernet, aux abris...

Friday, July 30, 2010

Thursday, July 29, 2010

NetApp à un virage ?

|

| Mark Leslie |

|

| Don Valentine |

Wednesday, July 28, 2010

Levée de 20M$ pour BlueArc

BlueArc (www.bluearc.com), un des leaders du NAS massivement évolutif notamment avec son offre Titan et plus récemment avec la gamme Mercury et déjà couvert à plusieurs reprises, vient de lever 20M$ pour accentuer et accélérer son développement. Espérons que la société fasse une IPO prochainement. 16 des investisseurs déjà présents ont participé à ce tour, signifiant ainsi leur confiance dans la société, ses execs, sa technologie et son futur. Le marché s'oriente fortement vers un NAS très performant, de plus en plus mutlti-environnements et applications, poussé il est vrai aussi fortement par la virtualisation. On se souvient du rôle clé que BlueArc avait joué dans la production du film Avatar il y quelques mois, la société va-t-elle franchir un nouveau cap ? la bataille s'annonce intéressante parmi les quelques grands du NAS...

Monday, July 26, 2010

S, E et maintenant N2000 chez Overland

Overland Storage (www.overlandstorage.com | NASD:OVRL) confirme son virage avec la sortie du troisième pilier - le N2000 - de la famille de stockage primaire déjà pourvue de l'unité de stockage bloc S2000 et de son extension l'E2000. Le N2000 est l'offre de stockage unifiée haut de gamme Overland qui propose un accès bloc et fichier sous un format 2U. L'appliance opère toujours sous GuardianOS, propose 6 ports GbE et une capacité maximale de 144To, sachant que chaque tiroir 2U héberge 12 disques. On retrouve des fonctions très pratiques comme ICE - Instant Capacity Expansion - et EDR - Enterprise Data Replication - qui complètent le snapshot et la gestion centralisée. Le prix de la première configuration s'établit à 5000$ et une promotion est lancée jusqu'au 24 Septembre qui double l'espace de stockage, pour 4To acheté, vous recevez 8To. Bravo, une très belle offre qui donne une vraie cohérence de gamme, monte le portefeuille vers le haut, tout ça à un très bon prix, on attend avec impatience l'intégration de SSD...

Saturday, July 24, 2010

SolidFire promet

SolidFire (www.solidefire.com) est une startup américaine d'Atlanta centrée sur le Cloud Storage se positionnant en tant que Cloud Technology Provider. Lancée il y a quelques semaines par Dave Wright anciennement CEO et fondateur de JungleDisk, acteur lui aussi du stockage et du backup en ligne grâce à son offre orientée Amazon S3 et Rackspace, acquis par Rackspace en 2008, la société a réussi à lever 1M$ fin juillet auprès de Valhalla Partners et Novak Biddle Venture Partners. L'idée est de fournir une souche logicielle pour la gestion de stockage en mode Cloud pour les providers Telco ou hébergeurs en configuration massive - milliers et dizaines de milliers de serveurs - en garantissant un gain de performance 100 fois supérieur pour 10% du coût grâce à l'utilisation intelligente de SSD, donc finalement au coût du HDD classique. SolidFire développe ainsi une logique scale-out - à évolutivité horizontale - unifiant un nombre important de serveurs de stockage pour proposer l'espace constitué sous forme d'une unité en mode bloc. La promesse est belle, on verra comment SolidFire la traduit en réalité... A suivre.

SolidFire (www.solidefire.com) est une startup américaine d'Atlanta centrée sur le Cloud Storage se positionnant en tant que Cloud Technology Provider. Lancée il y a quelques semaines par Dave Wright anciennement CEO et fondateur de JungleDisk, acteur lui aussi du stockage et du backup en ligne grâce à son offre orientée Amazon S3 et Rackspace, acquis par Rackspace en 2008, la société a réussi à lever 1M$ fin juillet auprès de Valhalla Partners et Novak Biddle Venture Partners. L'idée est de fournir une souche logicielle pour la gestion de stockage en mode Cloud pour les providers Telco ou hébergeurs en configuration massive - milliers et dizaines de milliers de serveurs - en garantissant un gain de performance 100 fois supérieur pour 10% du coût grâce à l'utilisation intelligente de SSD, donc finalement au coût du HDD classique. SolidFire développe ainsi une logique scale-out - à évolutivité horizontale - unifiant un nombre important de serveurs de stockage pour proposer l'espace constitué sous forme d'une unité en mode bloc. La promesse est belle, on verra comment SolidFire la traduit en réalité... A suivre.Friday, July 23, 2010

IBM Storewize c'est fait

Belle fin pour Storewize (www.storewize.com) qui se retrouve chez IBM pour environ 140M$ comme plusieurs autres sociétés high-tech innovantes d'origine israélienne, on a eu par le passé FilesX, Diligent ou XIV. On se souvient Diligent avait coûté 200M$ et Storwize arrive à point nommé pour compléter le portefeuille de réduction IBM. Vous vous souvenez à la venue d'Ed Walsh comme CEO chez Storwize j'avais indiqué en Septembre 2009 qu'il était venu pour vendre la société après Virtual Iron à Oracle et Avamar à EMC. Les utilisateurs commencent à recevoir une communication de la part de la société leur confirmant leur futur qui devrait être scellé d'ici fin Juillet. Ce mouvement confirme la volonté de propose une réduction de données sur le stockage primaire qu'il soit bloc ou fichier, Dell vient de prendre Ocarina, il reste parmi les quelques sociétés pertinentes ici: Permabit ou GreenBytes. On verra bien mais ces quelques acquisitions réactivent fortement les fusions-acquisitions et l'été y est souvent propice...

Thursday, July 22, 2010

Isilon repasse la barre du 1 Md$

Isilon (www.isilon.com | NASD:ISLN), pionnier et leader incontesté du scale-out NAS, publie des résultats canons pour son second trimestre à plus de 45M$ soit un gain de 15% séquentiellement et 56% par rapport au même trimestre de l'année passée. Sur les 6 premiers mois de l'année, le revenu est de plus de 84M$ dans un rapport 1/4 en service et 3/4 en produits. La marge brute s'élève à 62% et se maintient au même niveau que le premier trimestre et Isilon continue à afficher une profitabilité grandissante. Les investisseurs ne s'y trompent pas et le titre termine la séance à Wall street avec un gain au-delà de 20%. La valorisation de la boîte repasse la barre du milliard de dollars et Isilon pourrait donc avoisiner les 200M$ de revenu annuel dans quelques mois. Félicitations.

Monday, July 19, 2010

Dell s'offre Ocarina Networks

Surprise, grosse surprise, c'est Dell (www.dell.com | NASD:DELL) qui annonce la signature d'un accord pour s'offrir la pépite Ocarina Networks (www.ocarinanetworks.com). Ocarina fait figure de leader incontesté de l'Optimisation de la Capacité de Stockage (SCO) primaire souvent baptisée réduction de données associé à une très bonne qualité managériale, technologique et un sens de la pénétration du marché idéal pour ce type de solutions avec la signature de bons accords oems avec plusieurs leaders. Ce mouvement confirme la nécessité d'intégrer la déduplication sur le stockage primaire et en l'absence de cette technologie, la solution a peu de chance d'être adopté, elle devient le sésame. J'avais découvert Ocarina en Août 2007 et couvert par la suite à plusieurs reprises Avril 2009, Mai 2009 et Janvier 2010. On regardera maintenant la réaction du marché notamment des gros faiseurs avec leur propre offre mais aussi vis-à-vis d'acteurs comme Storwize en passe de passer chez IBM, GreenBytes, WhipTail, Nimble Storage, Permabit, Nimbus Data, Compellent voire FalconStor même si plusieurs fournisseurs de cette liste vont au-delà de la SCO. Bravo aussi à Dell qui opère de vraies acquisitions pertinentes depuis quelques trimestres. Félicitations.

Surprise, grosse surprise, c'est Dell (www.dell.com | NASD:DELL) qui annonce la signature d'un accord pour s'offrir la pépite Ocarina Networks (www.ocarinanetworks.com). Ocarina fait figure de leader incontesté de l'Optimisation de la Capacité de Stockage (SCO) primaire souvent baptisée réduction de données associé à une très bonne qualité managériale, technologique et un sens de la pénétration du marché idéal pour ce type de solutions avec la signature de bons accords oems avec plusieurs leaders. Ce mouvement confirme la nécessité d'intégrer la déduplication sur le stockage primaire et en l'absence de cette technologie, la solution a peu de chance d'être adopté, elle devient le sésame. J'avais découvert Ocarina en Août 2007 et couvert par la suite à plusieurs reprises Avril 2009, Mai 2009 et Janvier 2010. On regardera maintenant la réaction du marché notamment des gros faiseurs avec leur propre offre mais aussi vis-à-vis d'acteurs comme Storwize en passe de passer chez IBM, GreenBytes, WhipTail, Nimble Storage, Permabit, Nimbus Data, Compellent voire FalconStor même si plusieurs fournisseurs de cette liste vont au-delà de la SCO. Bravo aussi à Dell qui opère de vraies acquisitions pertinentes depuis quelques trimestres. Félicitations.Thursday, July 15, 2010

Nimble se dévoile enfin

Nimble Storage (www.nimblestorage.com), concepteur innovant d'une solution de stockage convergente, se révèle aujourd'hui. Pour ceux qui s'en souviennent, j'avais déjà couvert Nimble Storage en Avril 2009 et Mai 2009 en anticipant leur offre. Côté société, on retrouve essentiellement des anciens de Data Domain passés auparavant par NetApp, Panasas ou Zambeel et il est intéressant de noter le soutien financier de Sequoia Capital, Accel et Lightspeed Ventures, rien que des VCs fameux pas venus pour rien dans le projet mais pour faire une "sortie" à fort effet multiplicateur.

Nimble Storage (www.nimblestorage.com), concepteur innovant d'une solution de stockage convergente, se révèle aujourd'hui. Pour ceux qui s'en souviennent, j'avais déjà couvert Nimble Storage en Avril 2009 et Mai 2009 en anticipant leur offre. Côté société, on retrouve essentiellement des anciens de Data Domain passés auparavant par NetApp, Panasas ou Zambeel et il est intéressant de noter le soutien financier de Sequoia Capital, Accel et Lightspeed Ventures, rien que des VCs fameux pas venus pour rien dans le projet mais pour faire une "sortie" à fort effet multiplicateur.Il est important d'intégrer la différence entre Stockage Convergent et Stockage Unifié. Convergent signifie ici que plusieurs fonctions - logicielles et niveaux ou étages de stockage - sont assurées dans l'unité de stockage pour un seul type d'attachement externe ici iSCSI alors que le stockage unifié indique que la solution est capable d'être accédée au travers de plusieurs protocoles externes type iSCSI, FC et NAS. L'idée de Nimble est de répondre à quelques grands défis des infrastructures de stockage toujours plus gourmandes en surface disques et donc coûteuse en ressources IT, humaines et financières grâce au couplage intelligent du stockage et de la protection des données hébergées. Les grandes fonctions assurées par l'offre Nimble sont la déduplication disons compression et optimisation, tiering, backup local et distant grâce à un mécanisme sophistiqué de réplication auxquels s'ajoutent le thin provisioning, le Raid double-parité et le zero-copy cloning. La solution est donc autonome et se présente sous la forme d'au moins 2 appliances 3U de stockage asservis entre eux embarquant des unités Flash MLC d'origine Intel servant de Tier 0 et de 2 autres niveaux à base de disques SATA capacitif avec 4 ports GbE et déjà prêt pour le 10GbE. Les niveaux utilisés sont internes à une baie de disque pour satisfaire le niveau de service externe et les données dites très actives (hot) sont conservées sur disques Flash alors que les données moins utilisées sont naturellement déplacées vers les unités SATA. Les données sont injectées par le niveau Flash qui offre une compression en temps-réel des blocs de tailles variables agrégeant les informations afin de réduire le nombre d'opération d'écritures. Le dernier niveau sert de protection type backup disque interne à partir duquel est effectué la réplication incrémentale bloc entre les unités Nimble. Une telle unité peut stocker de 60 à 90 jours de données par l'intégration de mécanisme avancé d'élimination de la redondance. L'entreprise décline son offre en 2 produits le CS220 et le CS240 respectivement équipé de 640Go de Flash, 9To en SATA primaire et 108To de SATA de protection et pour le second, 1,3To de Flash, 18To de SATA primaire et 216To de SATA de protection. Le produit devrait être sur le marché en Août prochain à un prix attractif soit le CS220 à moins de 50k$ et le CS240 à moins de 100k$ ce qui, ramené à la capacité totale, avoisine les 400-450$ le To.

Nimble Storage avance la technologie CASL pour Cache Accelerated Sequential Layout comme pivot de toute son architecture, il est étonnant de voir que Data Domain avançait un acronyme assez proche SISL pour Stream Informed Segment Layout scaling architecture et bien sûr l'IP des 2 acteurs résident sur ces travaux, qui sera pour Nimble comme cela a été pour Data Domain, la clé de la valorisation. La philosophie en terme de produit résultant se rapproche donc d'une solution type EqualLogic ou LeftHand + Data Domain ou Quantum mais tout en un, ce que certains ne vont pas hésiter à sortir très vite également, certains offres existent déjà. La tendance se confirme donc de mettre sur le marché du stockage primaire à forte densité d'intelligence comme notamment l'élimination de la redondance aujourd'hui reconnue comme indispensable ou véritable sésame en ces temps de crise économique. Une très belle offre qui soigne sa mise sur le marché, une belle équipe et disons de très bonnes perspectives. Allez Messieurs sortez nous l'accès fichier NFS et pNFS. Félicitations.

Monday, July 12, 2010

La nouvelle pépite Clustrix

Dernier jour du voyage presse avec la visite d'une vraie pépite de la base de données Clustrix (www.clustrix.com) en leurs locaux du 1 Post Street à San Francisco. Et pour cause, on retrouve à l'origine du projet Paul Mikesell, CEO et VP Engr. et ancien fondateur d'Isilon, et Aaron Passey, CTO et lui aussi ancien d'Isilon, associés à Dan Liddle, responsable du Marketing et du Business Development, passé par quelques fameuses startups telles MaxiScale, Attune et NeoPath. Du beau monde qui a de quoi promettre... autrement dit, on s'attend à l'application "naturelle" des bons concepts Isilon à Clustrix. Et on n'est pas déçu. Coté entreprise, Clustrix est soutenu financièrement par Sequoia Capital, derrière de sacrés succès comme Google, Apple, Cisco, EA, NetApp ou Symantec, USVP et ATA Ventures et a reçu à ce jour 18M$ pour leur première levée.

Clustrix est parti du constat que les systèmes de bases de données largement éprouvés et utilisés aujourd'hui étaient limités et ne pouvaient garantir de bonnes montées en charge, souvent imprévisible, pour les applications très exigeantes comme celle des plus gros sites internet notamment les réseaux sociaux avec des millions d'utilisateurs, on ne parle plus de 5000, 10000 ou 50000 users. La messe est dite pour eux, les serveurs d'application et les systèmes de stockage peuvent et savent être très évolutifs mais les unités de bases de données arrivent rapidement à des limites.

La société adresse les 7 grands défis aujourd'hui d'une infrastructure base de données:

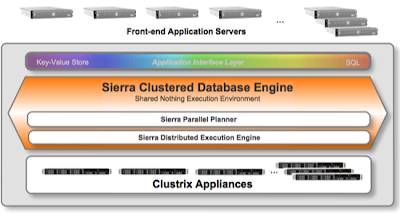

Clustrix a donc réfléchi, on peut leur faire confiance avec Isilon comme passé, à une troisième approche pour les besoins extrêmes de plus en plus fréquents et dédiée aux applications Internet à forte et rapide évolution de charge. L'idée originale réside dans 2 éléments clés: le maintien de la couche d'accès ici MySQL et la linéarité et évolutivité horizontale du back-end où on retrouve la propriété intellectuelle de Clustrix. Le résultat est la technologie parallèle et distribuée nommée Clustrix Sierra Clustered Database Engine capable de supporter le modèle relationnel et ACID SQL avec une couche massivement évolutive sur un stockage orienté "NoSQL key-value stores" à très haute performance. La partie Sierra est composée de 2 éléments: le Sierra Parallel Planner qui analyse et "coupe" les requêtes en fragments et les affecte aux noeuds appropriés pour exécution parallèle et le Sierra Distributed Execution Engine qui exécute les queries et retournent les résultats aux systèmes émetteurs.

La solution se présente sous forme d'appliance CDS - Clustered Database Systems - vendue par 3 unités minimum de nom CLX 4000. Chaque CLX 4000 est un système 1U avec 32Go de RAM, des cpus dual quad-core, 7 disques SSD de 160Go, 2 ports InfiniBand de 20Gbps pour le back-end inter-noeud et 2 ports 1GbE pour la partie frontale cliente. Le tout s'administre de façon centralisée en mode commande ou au travers d'une console web complète. La protection des données se complète naturellement par un mécanisme de réplication qui supporte 4 modes: 2 à l'initiative de MySQL et 2 contrôlés par Clustrix. La solution délivre des performances exceptionnelles avec 343838 TPS pour 20 noeuds et 798 threads clients à un prix extrêmement attractif, ce qui démontre un ROI rapide et réel surtout par rapport à une approche fédérée qui, de toutes les façons, coûtera en management et en développement spécifique non garanti toujours plus cher.

Le modèle de vente est purement indirect, les produits ne sont pas distribués en France même s'ils tournent déjà sur notre territoire. Clustrix devrait intégrer d'autres couches d'accès notamment Oracle et pourquoi pas dans un temps plus long une couche d'accès fichiers pour des besoins verticaux. Clustrix est une vraie pépite à découvrir d'urgence et qui bouleverse la donne du monde pourtant bien "stable" des bases de données... Paul Mikesell, CEO et fondateur de Clustrix, nous résume en quelques mots la mission et la solution qu'il a mis au point. Félicitations.

Clustrix est parti du constat que les systèmes de bases de données largement éprouvés et utilisés aujourd'hui étaient limités et ne pouvaient garantir de bonnes montées en charge, souvent imprévisible, pour les applications très exigeantes comme celle des plus gros sites internet notamment les réseaux sociaux avec des millions d'utilisateurs, on ne parle plus de 5000, 10000 ou 50000 users. La messe est dite pour eux, les serveurs d'application et les systèmes de stockage peuvent et savent être très évolutifs mais les unités de bases de données arrivent rapidement à des limites.

La société adresse les 7 grands défis aujourd'hui d'une infrastructure base de données:

- Les besoins de forte évolutivité en performance et capacité et la nécessité d'être linéaire,

- L'expansion incrémentale à chaud sans perturbation de la production,

- La haute-disponibilité et la tolérance aux pannes pour palier à toute interruption de service, il ne s'agit pas de repartir vite mais d'éviter tout simplement un arrêt même court,

- De très hauts besoins de performance en lecture et écriture,

- Une administration facile,

- Une souplesse de mise en place et

- Le meilleur TCO pour la qualité de la proposition.

Plusieurs tentatives et approches d'architecture base de données existent sur le marché et ont fait aussi l'objet de travaux de recherche universitaire ou d'entreprise:

- l'approche dite "shared-disk" où une seule base physique est "attaquée" par plusieurs instances tournent sur des systèmes différents. La performance et la disponibilité vient du concept de cluster mais on connaît les limites d'un tel modèle: la performance issue du nombre limité de noeuds supportés et de la contention entre ces mêmes noeuds. Certes des progrès ont été réalisés notamment dans les couches de messages et de synchronisation inter-noeud mais la forte évolutivité reste utopique. Le modèle est bon mais inadapté pour les besoins ciblés ici.

- le second modèle est le "shared-nothing" où on unifie N couples instance/système et base de données pour constituer un énorme référentiel de données. On appelle ce modèle le "sharding" en anglais pour fragmentation mais on trouve aussi le terme partitionnement, l'idée est donc de fédérer des distributions de SGBD(/R). En approche descendante, une base est "découpée" en segment avec 1 segment par système, l'union de tous ces segments représente la base complète, les requêtes sont aiguillées vers les bonnes instances et le tout est fourni aux client requêteurs. Ce modèle va plus loin et est capable d'adresser de gros défis mais se trouve limité plus loin sans être capable de rester simple puisqu'il introduit une complexité et une multiplication des noeuds et des segments.

La solution se présente sous forme d'appliance CDS - Clustered Database Systems - vendue par 3 unités minimum de nom CLX 4000. Chaque CLX 4000 est un système 1U avec 32Go de RAM, des cpus dual quad-core, 7 disques SSD de 160Go, 2 ports InfiniBand de 20Gbps pour le back-end inter-noeud et 2 ports 1GbE pour la partie frontale cliente. Le tout s'administre de façon centralisée en mode commande ou au travers d'une console web complète. La protection des données se complète naturellement par un mécanisme de réplication qui supporte 4 modes: 2 à l'initiative de MySQL et 2 contrôlés par Clustrix. La solution délivre des performances exceptionnelles avec 343838 TPS pour 20 noeuds et 798 threads clients à un prix extrêmement attractif, ce qui démontre un ROI rapide et réel surtout par rapport à une approche fédérée qui, de toutes les façons, coûtera en management et en développement spécifique non garanti toujours plus cher.

Le modèle de vente est purement indirect, les produits ne sont pas distribués en France même s'ils tournent déjà sur notre territoire. Clustrix devrait intégrer d'autres couches d'accès notamment Oracle et pourquoi pas dans un temps plus long une couche d'accès fichiers pour des besoins verticaux. Clustrix est une vraie pépite à découvrir d'urgence et qui bouleverse la donne du monde pourtant bien "stable" des bases de données... Paul Mikesell, CEO et fondateur de Clustrix, nous résume en quelques mots la mission et la solution qu'il a mis au point. Félicitations.

Thursday, July 08, 2010

Difficultés chez MaxiScale

MaxiScale (www.maxiscale.com) semble rencontrer quelques complications ces derniers temps. Gianluca Rattazzi, son ancien Président, CEO et co-fondateur, co-fondateur aussi de BlueArc, m'a d'ailleurs confirmé il y a quelques jours son départ vers Envivio en tant que Chairman malgré ce que mentionne encore le site MaxiScale. On retrouve plusieurs français à la tête d'Envivio, à suivre aussi pour la vidéo multi-device...

Monday, July 05, 2010

La preuve par l'image

Blade Network Technologies (www.bladenetwork.net) et VMware (www.vmware.com | NYSE:VMW) viennent d'organiser un séminaire très pertinent sur l'infrastructure nécessaire au Data Center virtuel. Blade a décliné l'étendue de sa technologie 10GbE et surtout VMready, une solution clé en main naturelle, immédiate et parfaite dans une contrainte de déplacement de machines virtuelles, autrement dit tout le temps. Retrouvez ci-dessous la présentation déroulée le 23 juin dernier.

Blade Network Technologies (www.bladenetwork.net) et VMware (www.vmware.com | NYSE:VMW) viennent d'organiser un séminaire très pertinent sur l'infrastructure nécessaire au Data Center virtuel. Blade a décliné l'étendue de sa technologie 10GbE et surtout VMready, une solution clé en main naturelle, immédiate et parfaite dans une contrainte de déplacement de machines virtuelles, autrement dit tout le temps. Retrouvez ci-dessous la présentation déroulée le 23 juin dernier.Thursday, July 01, 2010

Fusion-io ouvre une filiale Française

Quelques jours après notre visite chez Fusion-io (www.fusionio.com) à San José, je viens de rencontrer Marcello Spiga et Arnaud Laune, les 2 nouvelles recrues locales, qui seront responsables de la filiale Française. Marcello et Arnaud arrivent de F5 où ils ont poussé Acopia, Marcello est passé par Compuware, Micro Focus, Entrust, CheckPoint et DenyAll avant F5 et Arnaud est passé longtemps chez NetApp. Kevin Platz, VP EMEA, met ainsi en place une vraie stratégie de points de présence et de vente de proximité devant garantir à Fusion-io un succès rapide en Europe. Le bureau sera officiellement ouvert le 1er Août, rappelons le modèle de vente Fusion-io, vente indirecte mais "direct touch" chez le client notamment les comptes en attente de ce type de solutions et puis les oems qui assurent un train soutenu de revenu. Une grande partie éducation du marché devra être assurée par l'équipe afin de consolider les premières ventes fameuses. Fusion-io devrait annoncer de nouveau produits courant Juillet et prochainement des accords stratégiques assurant un avenir très prometteur au pionnier du Flash. La société avait réalisé pour l'année fiscale 2009 13M$, elle vient de clôturer l'exercice 2010 avec 65M$ soit une progression de 400%. Bravo Messieurs.

Subscribe to:

Posts (Atom)